Mãe processa empresa de IA por morte de filho adolescente; entenda

Uma mãe processa a Character.AI alegando que a interação com um chatbot influenciou a morte do adolescente de 14 anos; entenda o que aconteceu

Uma mãe está de luto pela perda de seu filho adolescente. Agora, ela está processando a plataforma Character.AI, alegando que a empresa de Inteligência Artificial (IA) tem responsabilidade pela morte de seu filho, que aconteceu na Flórida, nos Estados Unidos.

Megan Garcia descreve seu filho, Sewell Setzer, como inteligente e atlético, mas relata que começou a perceber que ele estava se tornando mais retraído após iniciar um relacionamento virtual com um chatbot no Character.AI, em abril de 2023, a quem ele chamou de “Daenerys”, baseado em uma personagem da série “Game of Thrones”.

É + que streaming. É arte, cultura e história.

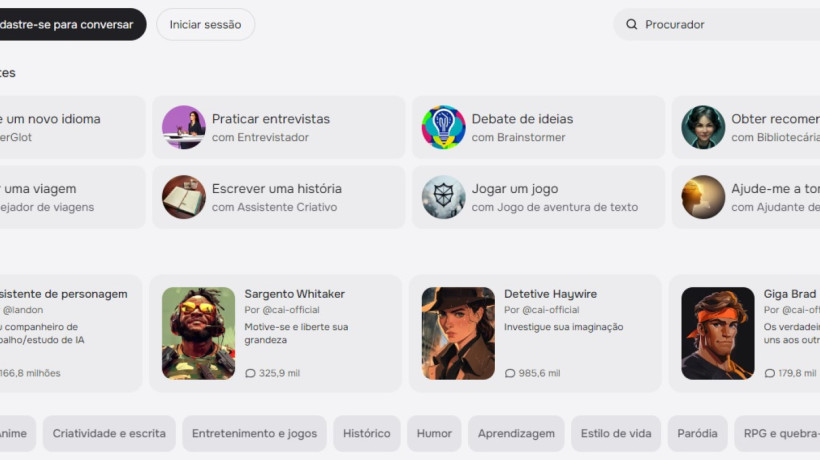

A IA em questão simula os trejeitos de diferentes personalidades, reais ou fictícias. A plataforma dá autonomia aos seus usuários para que eles mesmos possam criar essas personalidades distintas, que vão se moldando ao longo do tempo conforme interagem com outros usuários.

Inteligência Artificial já é uma realidade em ficções televisivas; VEJA

Sewell Setzer tirou a própria vida em fevereiro deste ano.De acordo com a Reuters, o processo foi aberto em 23 de outubro no tribunal federal de Orlando, Flórida, e inclui alegações de “homicídio culposo, negligência e inflição intencional de sofrimento emocional”.

Ela anexou capturas de tela de conversas que seu filho teve com “Daenerys”, que eram de natureza sexual, incluindo algumas em que a personagem disse ao jovem que o amava.

Garcia também incluiu o que afirma ter sido a última conversa de seu filho com o chatbot antes de ele falecer.

O Character.AI é uma das plataformas mais populares — especialmente entre adolescentes e jovens adultos — e afirma ter mais de 20 milhões de usuários ativos.

X muda termos de uso e utilizará dados para alimentar IA; ENTENDA

Mãe processa Character.AI: empresa se defende

Em uma publicação feita na terça-feira, 22, no site da empresa, a Character.AI informou que está intensificando os esforços para proteger a segurança de seus usuários, incluindo a introdução de “novas proteções para usuários menores de 18 anos”.

“Nos últimos seis meses, continuamos investindo significativamente em nossos processos de confiança e segurança e em nossa equipe interna. Como uma empresa relativamente nova, contratamos um Chefe de Confiança e Segurança e um Chefe de Política de Conteúdo, além de termos ampliado a equipe de suporte de segurança e engenharia. Essa é uma área em que continuaremos a crescer e evoluir”, dizia a declaração.

Além disso, a Character.AI declarou que adicionou um recurso em sua plataforma, que é acionado quando o usuário insere certas frases relacionadas à automutilação ou suicídio, direcionando-o a um órgão responsável pela prevenção do suicídio.

"Quem estiver passando por um momento difícil pode encontrar ajuda nos Centros de Atenção Psicossocial (CAPS), nas unidades básicas de saúde, ou no Centro de Valorização da Vida (CVV), que atende pelo telefone 188 ou pela internet", diz a mensagem da Character.AI.